員工可能更相信看不懂的AI

過去的研究顯示,員工通常對生成式人工智慧所提出的建議持有懷疑態度,這導致企業在建立了昂貴的AI系統後,卻無法充分發揮其效用。

這種現象與我們的直覺認知相符。由於機器學習和深度學習算法的複雜性,人們難以了解AI在產生結果之前的處理過程,這使得他們對AI的可信度產生極大的疑慮。

然而,在2023年9月的《哈佛商業評論》的一篇文章中,提到喬治城大學副教授提摩西·德斯帝法諾(Timothy DeStefano)等人與Coach母公司泰佩思琦(Tapestry)合作的研究中,得出了截然不同的結論。

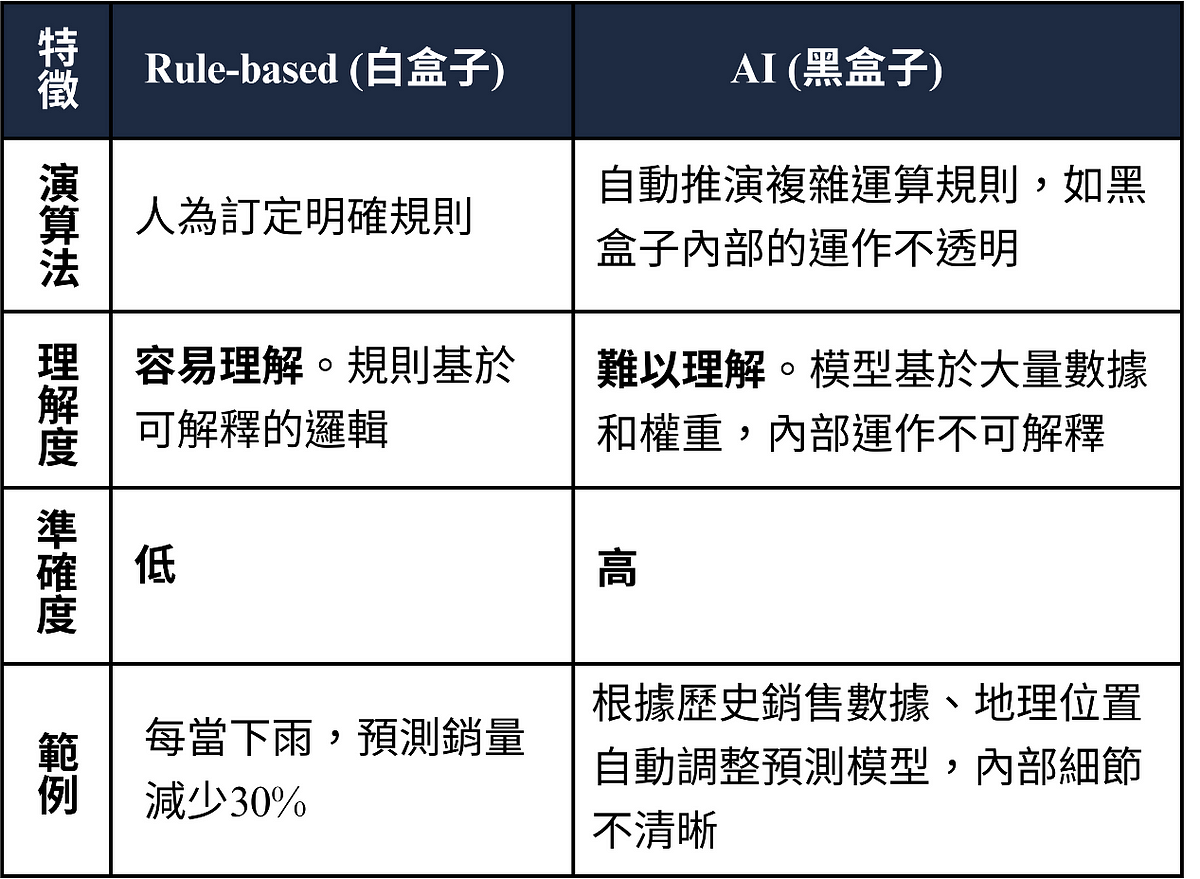

泰佩思琦擁有近1500家全球門店,最初使用的是基於特定規則(Rule-based)的演算法(白盒子),用於協助庫存分配決策。這種演算法基於固定規則推斷結果,易於理解(例如每當下雨時,進貨量減少50%)。為了提高準確性,泰佩思琦決定開始研究並引入更為複雜的AI模型(黑盒子)。如圖1所示。

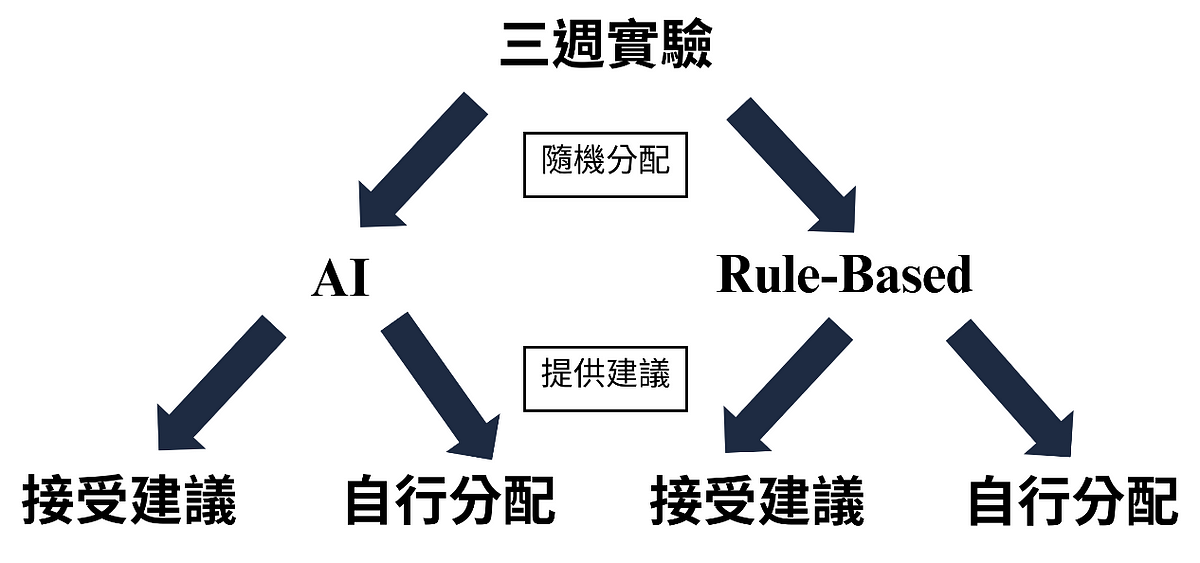

在為期三週的實驗中,德斯帝法諾教授隨機指派了規則式模型(Rule-based model)或人工智慧模型(AI model)來提供庫存分配建議,分配者有權根據模型建議調整運送數量,也可以自行做出決策。

根據實驗結果顯示,分配者更願意相信AI模型的建議。這一改變最終使總體營收增加了20%,同時也降低了缺貨問題的發生率。如圖2所示。

至於AI模型會勝出的原因,主要在於,相對於簡單模型,人們更容易接受機器學習的「黑盒子」,德斯帝法諾教授總結了以下三點:

1.過度自信

當面對簡單的模型時,分配者常認為自身對實際情況了解更深,因此會憑直覺或經驗調整簡單模型的結果。

舉例來說,當產品銷量再次飆升時,分配者可能會錯誤地歸因於國家美式足球聯盟(NFL)選秀,進而過於自信地修改了模型建議的數量。

2.對同仁的信任

儘管難以理解模型的推論過程,分配者仍然相信同事在開發過程中進行了多次驗證測試,因此對模型的準確性充滿信心。

例如,分配者提到:「我們信任的並不僅僅是模型提供的每一個建議,更在於我們的同仁參與了模型的開發過程,因此我們對這個模型有信心。」

3.巨大的不確定性

隨著決策的後果愈發重大,決策者內心的不確定感也隨之增加,特別是庫存分配對營收產生極大影響。因此,在面對簡單模型時,分配者傾向於深入研究並質疑其中的推論規則。

最後,該如何提高員工對於模型的接受度?

德斯帝法諾教授指出,企業必須持續評估員工對模型的信任程度。當AI提出與員工經驗不符的結論時,員工可能會懷疑模型的可靠性。在這種情況下,需要分析員工懷疑的原因,並有針對性地提供教育訓練。此外,讓模型的使用者參與模型的開發過程,可以建立信任感,並提高對模型的接受度。

黃揚博(政大企管碩士,識商創辦人)、羅凱揚(台科大兼任助理教授)

資料來源:https://hbr.org/2023/09/people-may-be-more-trusting-of-ai-when-they-cant-see-how-it-works

更多商普好文推薦

投放廣告之前,先學廣告分析(Advertising Analytics)

投放廣告之前,先學廣告分析(Advertising Analytics) 企業過去對廣告常常是又愛又恨,因為好的廣告會讓企業財源廣進,但隨著

購物若是一場混沌歷程,企業如何在混水中摸到大魚

購物若是一場混沌歷程,企業如何在混水中摸到大魚 搜尋引擎龍頭谷歌(Google)的英國市場洞察主管阿利斯泰爾‧雷尼(Alistair Ren