Chapter 05 行銷資料科學與大數據

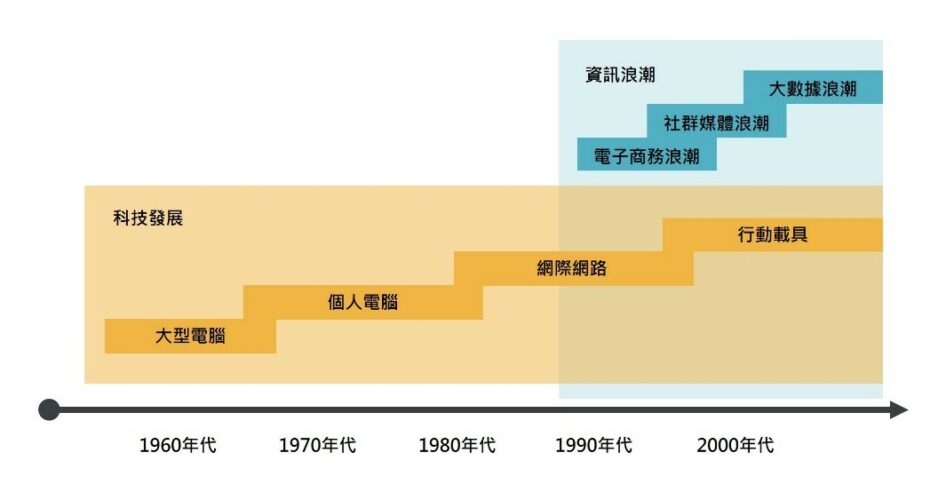

資訊科技發展越來越快,每一次電腦的進步都改變人類的文明,從「資訊載具」演變的觀點切入,大致可以分成四個波段:第一波大型電腦主機(Mainframe Computer)、第二波的個人電腦(Personal Computer)、第三波的網際網路(Internet),都為行銷資料科學奠定基礎,而到了第四波由行動載具(mobile device)才真正是掀起「大數據」資訊浪潮的關鍵所在。

圖1 科技發展促使大數據浪潮的出現

繪圖者:余得如

大型電腦的誕生,開啟了第一波資訊科技的發展,如圖1所示:。接著個人電腦的發明,讓電腦由研究機構普及到個人。當第三波網際網路出現後,電子商務(Electronic Commence, EC)與社群媒體(Social Media)的浪潮陸續成形。到了第四波行動載具的世代,則擴大且加速了電子商務與社群媒體的發展,同時,也促使大數據浪潮的出現。

一、科技發展促使大數據浪潮的出現

紐約時報2012年有一篇專欄「大數據紀元( The Age of Big Data)」開宗明義地指出,「大數據時代」已然來臨,無論在商業、經濟或者其他領域,未來決策的制訂將逐漸奠基於資料與分析,而非基於企業負責人的經驗與直覺。

當時,美國前總統歐巴馬(2012)也曾經打了個比方,大數據將會是未來的石油;馬雲(2015)也提出,未來最大的能源不是石油,而是大數據。這個比喻除了凸顯大數據的價值像石油一樣珍貴之外,也隱含著石油與大數據的構成,有些許相似之處。

多數的地質學家認為,石油是由古代海洋動物與藻類的屍體被掩埋在地底下所形成。這些看似不起眼的殘留物質,成為了現今巨大的能源。到了大數據時代,數據主要來自於人類在生活上所留下的點點滴滴。這些各式各樣看似沒有什麼價值的零碎資料,就散落在人們生活的各個地方。而這些深埋在各處的零碎資料要成為人類最強大的資源,就有賴行銷資料科學家,將它們一一開採出來。然而,整個開採過程,除了要有專家、有設備、有技術,還要有創意與想法。

舉個例子來說,2018年三月國內某家銀行在它舉辦的年度「大數據資料科學家競賽」,就首度將比賽分為「模型挑戰組」與「商業洞察組」,邀請對模型與演算法分析充滿創意和想法,以及有商業敏感度、充滿熱忱的大學生來比賽。表面上看來,比賽是希望達到結合理論與實務的目的來開發金融新業務,但深一層來看,其實挖掘大數據石油的過程其實還是充滿挑戰,因為連金融業界本身都對大數不是很清楚,還得依賴年輕學子的大膽嘗試。

大數據浪潮已經來臨,背後同時挾帶著巨大的機會與威脅。面對大數據浪潮,經理人必須做好決策,以確保企業能站在浪頭上,而非被浪潮所淹沒。

二、大數據(Big Data)的發展

在美國加州大學戴維斯分校任教的馬丁‧希爾伯特(Martin Hilbert)教授,回顧約180篇關於大數據分析的期刊論文,並於2016年發表了一篇文章[1]《 Big Data for Development: A Review of Promises and Challenges》,其中談到大數據分析的前景與挑戰。

[1] Hilbert, Martin (2016), “Big Data for Development: A Review of Promises and Challenges,” Development Policy Review, Volume 34, Issue 1, January 2016, Pages 135–174.

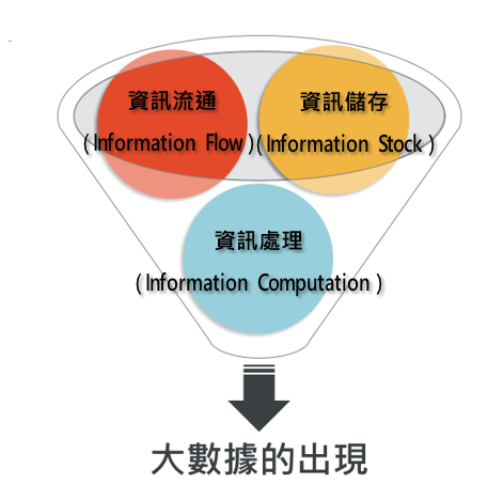

他歸結出今日大數據的產生,可由資訊流通、資訊儲存和資訊處理三項資訊發展來說明,如圖2所示。

圖2 大數據(Big Data)的發展

繪圖者:張庭瑄、王彥琳

1.資訊流通(Information Flow):

廣義的資訊流通,指的是人們利用各種方式來做資訊交流,從每天面對面的直接交談,到使用行動電話、電子郵件或是Line等各種現代化的傳播媒體都算是資訊流通。而如果再往深處探究,則又可分成資訊的傳遞、蒐集、貯存、檢索和分析的管道與過程。

至於狹義的資訊流通,則是從現代資訊技術研究、發展、應用的立場來看,指的是資訊處理過程中,資訊在電腦系統和通信網路中的流動。

希爾伯特指出,從1986至2007年之間,全球資訊交流的數量提升了近220倍,其中這些資訊數位化的程度自1986年的20%,成長至2007年的99.9%。而這中間的過程,人們把傳統的膠捲相機換成數位相機,將自己的影像資料貢獻出來,對於資訊流通有著莫大的幫助。

資訊流通在2007年之後,成長量更是驚人,因為智慧型手機、平板電腦的出現,配合內建GPS功能,大量記錄下各類資訊,未來還有物聯網(IoT)的加入,各種感測器亦加入記錄資訊的行列,更讓資訊流通量如洪水滾滾而來。

此外,資訊本身也會自我成長,在人工智慧中,機器學習是很重要的一支,意思是開發電腦程式,讓數據能在電腦系統中,自動變成資訊或知識。舉例來說,在自動駕駛車輛的電腦輸入所有交通規則,讓電腦自動學習,車子一上路之後,它就知道碰到十字路口要停等紅燈,碰到行人、幼童要避讓,原來的規則,經過電腦的自我處理變成駕駛知識,等於資訊也自我成長。

2.資訊儲存(Information Stock):

以往大家會把學校作業或者辦公室的文件儲存在電腦的硬碟,但現在大家已開始習慣將檔案丟到谷歌的雲端硬碟,或者丟到Dropbox裡來相互加工修改,資訊的儲存已透過網路來完成。

希爾伯特指出,資訊儲存的空間,大約每三年就成長一倍。資訊儲存的數位化程度,由1986年的1%,增加到2007年的94%。

3.資訊處理(Information Computation):

為了處理巨量的資料,世界大廠發展出分散式資料處理方式。例如:Google的GFS、 MapReduce與Bigtable,即是因應這樣的發展趨勢而誕生。而民間或者個人也不必擔心巨量資料無法處理,現在也有許多開放軟體讓個人可以處理大數據,像是Hadoop等。

今日的大數據,就在資訊流通、資訊儲存、資訊處理這三項的發展中誕生。

災後大數據分析計畫

2011年3月11日,日本東北部發生了芮式規模9.0的強烈地震,30分鐘後,巨大的海嘯淹沒了日本東北的許多區域,受災地區主要集中在東北、北海道、關東地區,尤其距離震央最近的福島、岩手、宮城等三個縣,沿海地區遭到巨大的海嘯襲擊,離海岸數公里的地區遭海嘯淹沒,沿海城市遭到大浪無情摧毀,死亡及失蹤人數更是難以估計,這場災難後續還帶來核電廠損壞的重大損失。

事後,儘管天災無法避免,但日本政府為了亡羊補牢,利用各種科技設備希望來降低下次面臨災害時的可能損失。而其中一個備受矚目的,就是「災後大數據分析」計畫。這項畫藉由分析地震之後一週內的一億八千萬條推特推文、事發當天該地區140萬輛汽車的導航紀錄,以及災民手機定位等行動資料,企圖得到有用的資訊,進而協助相關單位做出未來災難發生時的預防性決策。

研究單位從所收集到的龐大數據,分析出許多的驚人真相。首先,從受難者手機GPS定位所顯示的位置,調查卻發現許多受難者聚集在政府所指定的疏散點。大批民眾到達這些疏散點後,很多驚慌逃難的民眾以為自己安全了,結果卻沒有算到浪高超過預期,也因此讓更多人死在自以為安全的所在。如果當時這些受難者能把握時間,逃到較高的地方,也許就會有更多的人因而獲救。

其次,大數據分析同時也發現,發生地震時,在即將淹沒的地區大約有2,1000人,但到了海嘯來臨後,這些區域的人數不但沒有減少,反而還逆向增加。研究人員當初還無法理解,為何這些民眾明明知道即將會有海嘯的威脅,但還是進入即將淹沒的地方。在研究人員抽絲剝繭的追查下,對汽車導航數據所進行的分析,才證實許多人在地震發生後,都開車立即掉頭趕回家,希望去接家人。但最後卻卡在車陣裡,直到無情的海嘯湧來。

經由大數據分析後,日本政府後來召集防災、醫療等單位,以及自衛隊、企業等相關的機構組織,共同研討如何利用大數據分析的結果,建立未來防災的新系統體系。從311大地震的案例來看,大數據分析不但能協助找到問題的真相,也有助於未來有效決策的制定。

<<本頁僅供試讀,若須閱讀完整章節歡迎參考行銷資料科學>>

行銷資料科學|大數據x市場分析x人工智慧

出版社:碁峰

出版日期:2019/07/30

語言:繁體中文

定價:520元